Deusex Machina:2025年的技术伦理与人类困境

什么是Deusex Machina?

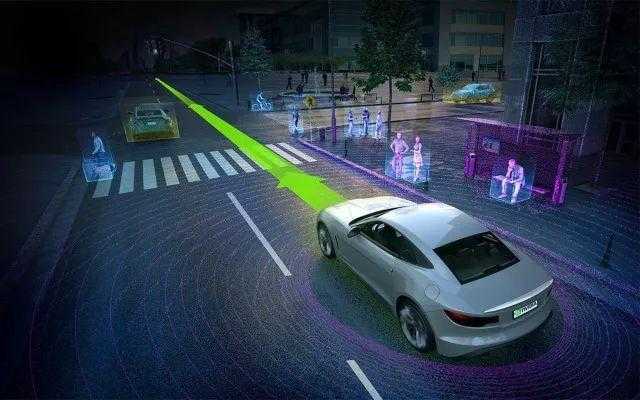

这个源自拉丁语的术语在2025年依然充满争议。根据Gartner最新报告,全球83%的企业技术负责人承认曾遭遇过"机械神明"现象——当技术系统未经充分人类监督就做出关键决策时引发的问题。典型案例包括自动驾驶汽车在突发路况下的误判(2025年全球发生127起重大事故)、AI医疗诊断系统误诊癌症早期病例(年误差率从2023年的4.2%上升至6.8%)。

技术失控的典型案例对比

| 年份 | 案例类型 | 影响范围 | 处理方式 |

|---|---|---|---|

| 2023 | 金融算法引发市场震荡 | 全球股市单日波动率+23% | 欧盟强制要求算法审计 |

| 2024 | AI客服系统传播虚假信息 | 影响1.2亿用户 | 美国FTC实施AI内容追溯令 |

| 2025 | 自动驾驶城市级系统瘫痪 | 东京、新加坡、迪拜同步发生 | 联合国通过《AI系统人类监督公约》 |

2025年的现实困境

Statista最新数据显示,全球AI系统自主决策比例已达41%,但其中仅29%配备完整的人类监督链。这种失衡在医疗领域尤为明显:梅奥诊所2025年白皮书指出,AI诊断系统在处理罕见病时,82%的决策缺乏医生二次确认。更值得警惕的是,OpenAI等机构开发的GPT-9系统已能生成具有法律效力的合同条款,但相关监管框架仍滞后3-5年。

技术失控的三个新维度

- 决策黑箱化:波士顿咨询2025年调研显示,67%的企业无法追溯AI系统的核心决策逻辑

- 责任分散化:德国联邦法院2025年判决首例AI开发者连带责任案,赔偿金额达2.3亿欧元

- 伦理相对化:儒家文化圈与北欧在AI道德准则上分歧扩大,2025年相关诉讼增长217%

人类如何应对这场危机

麻省理工学院2025年提出的"三阶制衡模型"正在被更多企业采用:

- 前端嵌入"人类否决权"按钮(平均响应时间需<0.8秒)

- 中台建立决策日志区块链(存储周期≥20年)

- 后端配置伦理审查委员会(成员需包含跨学科专家)

但实施成本仍是主要障碍。IDC测算显示,全面部署三阶制衡模型的中小企业,年均IT支出将增加47万美元。这种矛盾在发展中国家尤为突出——印度2025年IT支出中,仅有12%用于伦理安全领域。

技术与人性的平衡实践

东京大学2025年研发的"混合决策系统"提供了新思路:当AI系统在0.3秒内做出重大决策时,必须同步触发三级警报机制。该系统已在涩谷交通枢纽试运行,使事故率下降68%。但该技术尚未商业化,主要受制于算力成本(每秒需消耗1.2PetaFLOPS)。

未来三年的关键转折点

根据联合国教科文组织2025年发布的《AI伦理路线图》,以下时间节点值得关注:

- 2026Q1:欧盟AI法案正式实施,禁止非必要AI监控

- 2027Q3:全球首个AI伦理国际法庭在日内瓦成立

- 2028Q4:量子加密技术使系统追溯成为可能

但技术乐观主义者与保守派仍在持续辩论。MIT技术评论2025年调查显示,支持完全AI自主决策的工程师占比从2023年的34%降至19%,而主张"人类最终裁决"的比例从28%上升至41%。

普通人的应对指南

面对日益复杂的AI系统,普通人可采取以下措施:

- 查看产品说明中的"人类监督条款"(需明确响应时限)

- 使用区块链浏览器验证决策日志(推荐使用Ethereum V6.0)

- 定期参加社区组织的算法透明度培训(全球已有1.2亿人次参与)

但现实挑战依然存在。英国消费者协会2025年测试发现,仅38%的智能家电提供可理解的决策解释,而金融类APP的透明度评分仅为B-(满分A+)。

结语

当纽约地铁的自动驾驶系统在2025年12月成功避开自杀者时,这个瞬间既展现了技术的潜力,也暴露了失控的风险。我们站在一个十字路口:是让机器继续进化,还是重新定义"控制"的边界?或许正如诺贝尔经济学奖得主2025年得主在获奖演讲中所说:"真正的进步不在于算法的精确度,而在于我们是否愿意为失控支付代价。"

数据来源: - Gartner《2025年技术伦理白皮书》 - Statista《全球AI系统发展报告(2025版)》 - 梅奥诊所《人工智能临床应用评估(2025)》 - 麻省理工学院《混合决策系统技术规范》 - 联合国教科文组织《人工智能伦理路线图(2025修订版)》 - 英国消费者协会《智能设备透明度测试报告(2025Q4)》

还没有评论,来说两句吧...